日历翻过一页,我们来到了2021,虽然生活并没有质的改变,我们都期望新的一年和2020能有所不一样。可现实是,没有期望,就没有失望。虽然听上去,消极了一些。但与其把目标定的过高,愿望定的太美好,导致与未来的现实有巨大落差,不如放平心态,有智慧做出当下最好的选择,有勇气去接受相应的结果,无论好与坏。尽人事,知天命。不以物喜,不以己悲。

人生当中的每个瞬间都是千年一遇,错过了就不会再重来,也没有机会去修正。2020年真的是太魔幻的一年。新冠疫情最终还是没有控制下来,蔓延到了世界各地。由此引发的经济萧条,美股熔断,原油负价,零利率,黄金比特币美股历史新高,各国停航,奥运延期,还有接下来的通胀。时代的一粒沙,落在每个人的身上,就是一座山。小到生活不便,大到生离死别。身边好多朋友的人生轨迹也因为新冠,发生了很大的变化。

年初的我是幸运的。因为美签被check,去年年底没有成行美国。因为找工作,过年的时候也没有回家,因此躲过了国内的新冠。然后,也顺利的在新冠全球大暴发之前,找到了一家对冲基金的工作。可能人生就是这样,有起有伏。我觉得我之前的人生基本走的都很顺,童年幸福,家庭和睦,本科拿到了美国数学建模竞赛的全球最高奖,博士也发了控制领域的顶刊,现在工作也是我最喜欢的选择。但是人生就像一盒巧克力,你永远不知道下一颗是什么味道。年末的时候,我才体会到什么叫做天塌了。之前有人问我,相不相信平行宇宙,此刻的我却是期盼有所谓的平行宇宙。

12月6号的时候,父亲在他介入手术前一天,告诉我他体检发现有原发性肝癌II B期,肿瘤还比较大。当时的我真的觉得世界失去了原有的色彩,变得灰蒙蒙的,整个人也变得恍惚起来,夜不能寐,茶饭不思。振作起来,发动身边的朋友资源,拿着我爸的检查结果去到处问,想找到当前最好的解决方案。真的非常感谢这些朋友们,有些素不相识,但都非常耐心而且贴心的回答我的各种问题。也非常感谢公司老板和同事,让我能够在中国远程工作。一切交待过后,确定好初步的治疗方案,订了我生日那天的航班从新加坡飞往中国。原本只需几个小时的行程,因为新冠被放大到14天。不过这也是不幸中的万幸,起码还有航班能飞到中国。隔离只剩5天了,加油!

前几天收到了达里奥的邮件,说到因为车祸,他失去了42岁的儿子。白发人送黑发人,这般伤心也必定是刻骨铭心,难以想象的。学校里的教育,很多都没有教到,包括面对死亡,人生的意义。上天是公平的,所有人都是一天24小时,凡人皆有一死。人有悲欢离合,月有阴晴圆缺,此事古难全。但正如达里奥所说的pain+reflection=progress,要向生活这个大课堂需要学习的还有很多。那些杀不死你的,终将使你更强大。一个人可以被毁灭,但不能被打败!

进去看看

今天是21世纪20年代的第一天,可能也是因为这个缘故,昨天才显得格外的特别。毕竟我们告别了又一个十年,迎接下一个十年。初中课本里讲到的2020年中国实现全面小康社会的时间点也将来临,第一批90后也将逐步跨入而立之年。着实会感觉到一些惶恐,莫非这就是中年危机提前到来了嘛。

想着十年前的这个时候,我还在高三,想必刚刚结束数学竞赛和计算机竞赛。记得那一年雪下的尤其的大,我每天的生活基本一成不变,白天上课,晚饭吃个白糖饼夹麻辣串,然后就去学校机房练习算法题了,刷完题再去食堂买个馍夹里脊当做夜宵,睡前看会格言杂志。虽然大家都说高三的生活很苦,但我现在觉得那个时候的生活简单而不乏味。现在的自己虽然每天都会玩会游戏看会视频来放松,但却觉得有些空虚。

五年前的这个时候,我还在博士一年级。当时第一学年秋季学期的7天假期也没有请掉,现在想想还是挺可惜的。然后过一阵子马上又要开学了。想起来第一学期的6002,作业真的是好多,然后当时随机算法课程的大作业也真的是特别有意思。那个时候也刚刚开始了第一个研究工作,做多目标计算仿真资源的最优分配,紧张而兴奋。

三年前的这个时候,我记得当时在实验室改文章跨年。几个好朋友相约去台湾玩,其实还是挺想去的,但是第一篇文章的修稿快要截止了,遂作罢。当然开心的是,这篇文章后来也很快接收了,发表在了控制领域的顶刊上面。那年的我才24岁,想想还是蛮年轻的。

回忆杀就到此结束了,岁月真的催人老啊。前一阵子,有人问我,有没有感觉自己变老了。虽然不想承认,但确实会往这方面想,身体和记忆都大不如从前了,更可怕的是父母也一天天变老,陪在他们身边的时间也越来越少了。像去年一样,也选一首歌作为主旋律吧,虽然跟我没有半毛钱的关系,但真的好感动。这首歌是林俊杰的“将故事写成我们”,今晚就有MV啦,好期待。“这一生,原本一个人。你坚持,厮守成我们。却小小声,牵着手在默认。感动的眼神,说愿意,走进我的人生。进了门,开了灯,一家人。执子之手,如此温柔。天长地久,并肩走。你深情,凝望着我说。幸福,是你,有了我。”

进去看看

戊戌年腊月廿七,携基友一人,于暹罗湄南河,乘璀璨珍珠号,品美食,饮佳酿。拾级而上,登甲板。天地之间,浩浩汤汤,忽觉人生之短暂,宇宙之浩瀚。沿河可观大皇宫,卧佛寺,郑王庙,金碧辉煌,奢靡至极。亦有ICONSIAM,RiverCity相伴,不乏LV卡地亚点缀其间。往来之间,千帆竞发,百舸争流。忽闻男女二人曼妙歌声,诉乡情,诉友情,诉爱情。可谓初闻不知曲中意,再闻已是曲中人。愿一曲后来,愿诸君不离不弃,愿莫辜负梦中人。抑或纵使相隔几万里,情若在,成正果;抑或纵使相逢应不识,尘满面,鬓如霜。仿若生死,你在那头,我在这头。

『后来,我总算学会了如何去爱,可惜你早已远去消失在人海;后来,终于在眼泪中明白,有些人一旦错过就不再。那时候的爱情,为什么就能那样简单;而又是为什么,人年少时,一定要让深爱的人受伤。在这相似的深夜里,你是否一样也在静静追悔感伤。如果当时我们能不那么倔强,现在也不那么遗憾。你都如何回忆我,带着笑或是很沉默。这些年来,有没有人能让你不寂寞。永远不会再重来,有一个男孩爱着那个女孩。』

进去看看

2017年阳历的最后一天,大雨一直浸蚀着整个新加坡,带走了这一年的点点滴滴。无论是开心的,亦或是悲伤的,都随着这涓涓细流消失在四面八方。一大早我便去了实验室,希望新的一年也能像今天这样,工作努力,懂得知足。实验室里的人,零零散散。来了一个,又走了一个。每个人都在自己的人生节点里做出种种选择,或大或小。就这几天,我们这些90后们还分分晒自己18岁的照片。因为到了2018年,00后们也都渐渐的成年了。时代的洪流冲刷着我们每个人的命运,冲散了我们曾经以为的海誓山盟。既要不忘初心,也要拥抱变化。

2018年阳历的第一天,雨停了,虽然天仍旧是灰蒙蒙的。除了四周春意盎然的花草树木,但这一丝丝凉意也竟让我想起了故乡的秋天。一层秋雨一阵凉,一瓣落花一脉香。一样流年自难忘,一把闲愁无处藏。2018年,对我而言有太多变数,也有太多的人生选择。相信多少年过后再回首,一定会铭记这一年所做出的努力与决定。虽然现在的我依旧迷茫,但毕竟路都是人走出来的。我也要迈着坚实的步伐,度过一个个难关,向着美好走去!

进去看看

本科的时候就听说XJC师兄想要从零开始搭建一套量化交易系统,当时也是特别佩服。虽然周围金工的同学或多或少也在用SAS然后连接Wind来开发与回测投资策略,少部分同学也试着实盘去操作,但真正从一砖一瓦去搭建整个量化交易系统就是另一回事了。 后来大概在我大四的时候,预测者网诞生了。一开始其核心在于抓取大V以及分析师们的预测观点并进行评级,之后逐步开始卖量化投资策略和高频数据。 之所以以这个引子开头,是为了契合Quantopian这次的量化投资大会。一来,随着2016年国内各大量化策略平台(RiceQuant, Uqer, JoinQuant, 果仁网)雨后春笋般的出现,人人皆为宽客的时代已然来临,预测者网虽然没有很快的转型,但也是这波浪潮的冲锋号。二来,alternative data近来也比较火,正如有着GIC九年工作经验的keynote主讲人Yi Li大神提到用分析师数据来预测宏观市场状态,预测者网也有试图整合所有分析师的预测观点来最大化集体智慧。三来,机器学习/人工智能也算是在各个行业都大放异彩,这次QuantCon有很多演讲都和机器学习、增强学习有关。另外,文末有福利放送哦~

进去看看

无论做什么事,多尝试、找套路、然后刻意练习都是至关重要的。对信息科学竞赛(Olympiad in Informatics)爱好者来说,找套路的关键就是多刷题。然而题海茫茫,单以Codeforces来说,截止2017年1月3日,总共有3206道题。换言之,如果一个人足够勤奋,能够一天刷三道题,那也得快三年才能把题目刷完,而且题目数量还在扩充。所以盲目的刷题简直是浪费生命,本人从16年上半年一直按照题目解决人数从高到低排序,不断的刷水题。显然易见,刷水题的后果就是没有长进,熟悉的还是熟悉,不懂的还是不懂,唯一让自己开心的就是刷题数量的累积。所以科学刷题的本质在于不断挑战新高度,在一个平台练习足够久足够熟练之后,就要进入下一个难度平台。为了方便大家,我把Codeforces上截止2017年1月3日的所有题目的基本信息用爬虫收集了下来,并存储到excel里。更进一步,本文试图分析不同算法在不同难度等级上的出现频率分布,以及不同算法在不同难度等级上被解决次数的分布。最后,我会简要介绍的我的刷题观,以及如何爬取Codeforces上的信息。

进去看看

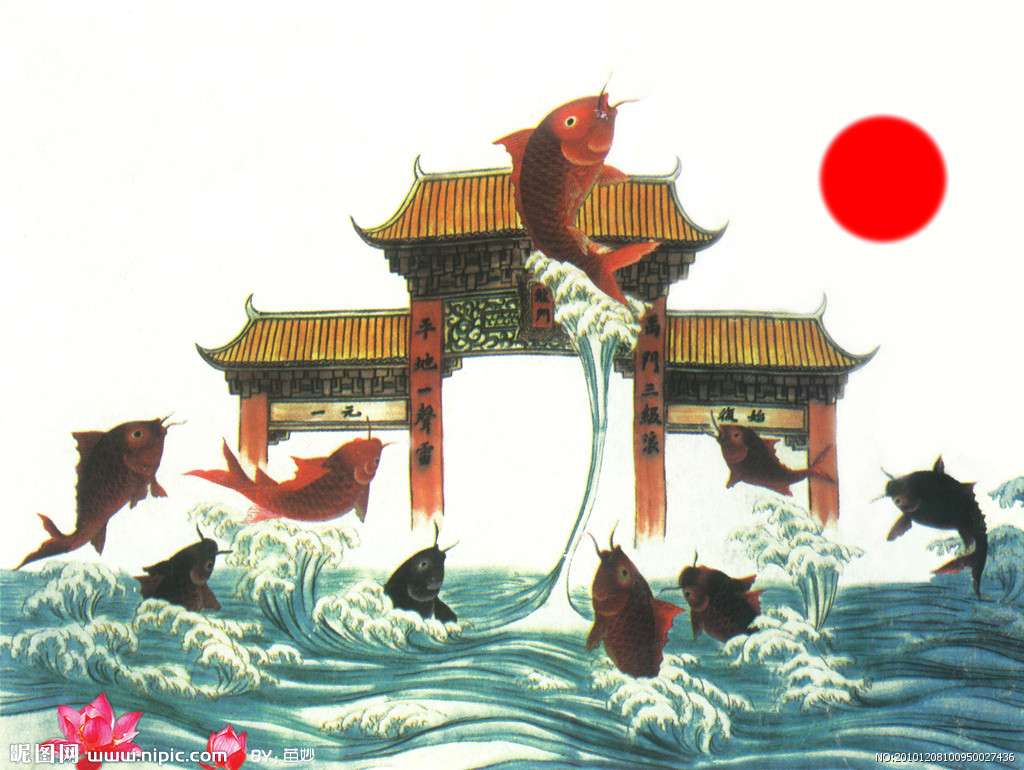

计划、组织、领导、控制,这恐怕是学过管理的人都耳熟能详的四个词。凡事预则立,不预则废。我想目标还是讲出来、写出来的比较好,一来有个靶子知道自己要做什么,二来心里可以惦记着也算是一种鞭策,三来也有个监督立flag的意味。其实大部分的目标,无外乎就是靠时间来换取结果,有个阶段性的计划也好对抗自己的拖延症,要不就陷入自己的舒适区无法前进。就像鲤鱼跃龙门一样,跨过了这个槛,才能有新的平台和视野。感觉毕业两年半,周围的同学都在大踏步的前进,而我还在原地踏步,实在是太惭愧了。在这里列出我2017年的小目标,通过每个季度的追踪以及校正,希望在新的一年能有所收获吧。

进去看看

风过留声,雁过留痕。一天又一天,一年又一年,总觉得小时候的时光很漫长,而越长越大却觉得时间飞逝,稍不留神自己就老了。关于这个时间相对性,有人这样解释道,假如你今年 \(N\) 岁,那么这一年相当于你人生中的 \(1/N\) ,自然年龄越大对时间流逝的敏感也就越来越小(见这里)。 换句话讲,时间对人的效用是边际递减的。年少时一无所知,用20%时间学习了80%的源头知识;长大后有所攻,用80%的时间学习或者提出了20%的扩展性知识。尽管如此,抛开数字而言,这2016年无论对谁而讲,都是鲜活的一年。就像每个人都是一本书,有了酒,有了观众,便有了故事。赶在这2016年的尾巴上,让我做一回瞬间收藏家,用光影来记录我的2016年。谢谢2016年我遇到的所有人,如果没有你们,这也不会成为我的2016年。

- 年初约定要发论文,经过半年的审稿再四个月的修改希望一切能遂愿吧,另外一篇QE结束之后就没怎么管了。

- 年初说但求虐狗,也从一份友情收获到了真挚的爱情,虽然有着各种阻隔,但还是谢谢你给我的快乐时光。

- 年初说要开发量化交易系统,虽然没有实现,但也借着今年初露锋芒的各大量化平台实现了几个还凑活的策略。

- 年初想着在codeforces上再进一步,刷了半年题直到年尾重新拾起,发现自己只是在舒适区划水。

进去看看

有的人苦于没有选择可选,只能一条路走到黑;而有的人选择过多、权衡过多,反而无从下手,相当于没做选择。约束太多有约束太多的烦恼,太过自由有太过自由的烦恼,这也算是一种 资源诅咒 吧。 然而面对选择困难症,到底有没有灵丹妙药来解决它。科学家说,必须有! 先来考虑一个问题,某天你走了狗屎运天上掉下了1000块钱,你觉得自己的运气正旺,而且反正是不义之财,不如去赌场来以小博大。赚了算自己的,赔了就当没捡过这钱。你兴冲冲的跑去了赌场去玩老虎机,然而到了赌场却傻了眼,竟然有200台老虎机!随便选一个老虎机可不行,因为你听人说过有的老虎机赢率比较高,有的比较低。那么问题来了,给定这1000块钱,假定玩一次老虎机要支付1块钱,那么应该玩哪些老虎机、以怎样的顺序去玩才能使得自己的累积收益最大?在 上篇深度增强学习系列文章, 我们讲到了Alpha Go中的两个关键技术:深度学习和增强学习。 本文将首先介绍 多臂赌博机问题 (Multi-armed Bandit Problem),然后基于此,介绍Alpha Go的另一项核心技术,即 蒙特卡洛树搜索 (Monte Carlo Tree Search),最后会简要介绍我的研究方向 仿真优化 (Simulation Optimization)同这些领域的关系。

进去看看